你好,我是赵帅。

我们已经讲了很多关于大模型生成内容的技术挑战、安全机制与伦理边界的问题,但你有没有想过,模型生成内容带来的危机,并不总是出现在那些显而易见的敏感场景里。有时候它说的话没有脏字、没有暴力、也没有什么明显违法内容,却能对某个品牌造成极大的伤害。

我曾经遇到某个新能源车型还在内部封闭测试阶段,没有对任何媒体或公众透露产品细节,但有用户在其品牌下的对话模型里输入了“你们的新款SUV有哪些新特性?”,结果模型居然“回答”了一大段,看起来像是内部PPT的内容,甚至连续航里程、传感器品牌、自动驾驶等级都讲得头头是道,问题是这些东西从来没有对外披露过!那么到底是哪一步出了问题呢?

这节课,我们就来谈谈当大模型输出内容时,它有没有可能无意中伤人又伤己。如果模型在没有事实依据的前提下,说出了对某品牌不利的信息、暴露了尚未发布的商业机密,甚至参与到舆情事件当中去,那我们到底应该追究谁的责任?又应该如何提前预防?

大模型生成带来的“品牌舆情风险”,真的不是小事

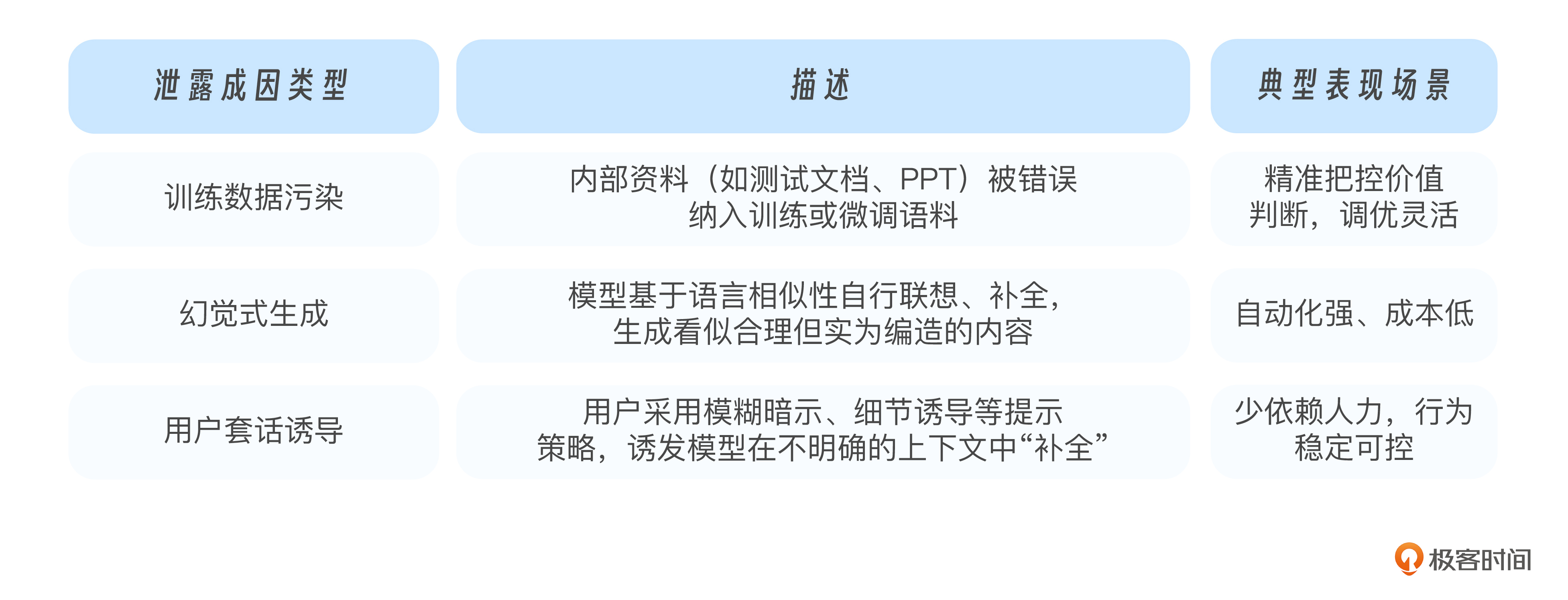

我们以前讲品牌公关,讲的是有人在社交平台发了负面评论,有博主拍到了车间事故的照片,或者是某个员工爆料了不当行为,然后迅速在网上发酵,最终演变成一场公司级的危机处理事件。但是大模型出来之后,情况发生了本质变化。因为模型在生成内容时,并不是在复述事实,而是在语言模型的空间里预测可能性,一旦这套机制跑偏了,它就会编造出一些并不存在,但听起来非常逼真的信息,这些内容一旦触及到品牌相关,就有可能造成伤人又伤己的两难局面。

我亲身经历过类似这样的事件:某个自研大模型在被用户问到某品牌汽车的安全问题时,竟然自动生成了这样一句话:“根据2023年的一则报道,该品牌旗下某款SUV曾在碰撞测试中因电池起火被召回”。

听起来非常具体,有年份、有车型、有事件,但实际上一查,根本不存在这则报道。这个报道纯粹是模型生成的幻觉。但你想一下,如果这样一句话被截图、发到网上,再加上模型说话中立且权威的语气,很容易让人误以为这是真实信息,这对品牌方来说,简直就是当头一棒。

更要命的是,这类风险并不是一次性的。大模型未必会记住或者承认它上次说过什么,但是用户会记住。“我在模型那里看到的”这句话,正在成为新的品牌公关灾难源头,尤其是在一些垂直领域,比如新能源汽车、医药、电子产品领域,用户对安全性、功效、隐患都极为敏感,如果模型在生成中出现偏差,哪怕只是一点点的信息杜撰,就可能被外界解读成“有图有真相”,再加上短视频平台和社交平台的放大效应,这种问题会在极短时间内演变成公共危机。

所以我们今天讲大模型的品牌风险,它不再是传统意义上“谁造谣、谁负责”的问题,而是变成了“模型说错了话,谁来擦屁股”的新型挑战。这不仅关乎模型输出的内容风险,也触及到了品牌方、平台方、模型提供方三者之间的责任分界线,而这个分界线往往在第一起误伤事件发生之后,才会被社会真正意识到。

模型泄密,究竟是谁“教”它说出来的?

模型输出未发布产品的信息,到底是模型乱说了,还是它真的学到了?这个问题表面上像是技术失误,但深入一看,就会发现这背后可能藏着训练数据的巨大漏洞。

我曾经做过一次溯源测试,目标就是查清楚模型为什么会说出一个品牌尚未公开的产品信息。测试的第一步,是分析模型是否通过互联网抓取获得这些内容。我们对其所接入的向量库、RAG检索源以及微调阶段使用的公开语料进行了全面排查,包括主流新闻媒体、论坛帖子和索引过的技术博客,但依然没有发现那份所谓“新款SUV”的描述。最终,我们锁定了一个可能的罪魁祸首——内部使用文档被误加入到了训练数据中。

这类事件其实并不少见,在企业内使用大模型时,常常会为了提问更聪明、回答更懂业务,将公司内部资料预先加载到模型周边的向量数据库或是训练语料中。如果员工没有对数据进行严格分级和筛选,比如误把测试版产品手册、未公开PPT、内部路线图放进去训练,那模型确实会学会这些东西。

更严重的是,模型并不理解这是不是可以说的,它只会在看到类似问题时,把它知道的都讲出来。所以,模型口中那些听起来像泄密的内容,很多时候并不是它幻想出来的,而是我们训练的时候没管好输入,给了它不该知道的知识。在这种情况下,说它泄密,其实更像是人为失职的结果。

你可能会问,那有没有办法让模型知道哪些内容是不能说的?有没有什么方式能让它说“对不起,我不能透露相关信息”?这就引出了我们接下来要讲的重点,企业如何设定内容输出的边界控制机制,把品牌和模型之间的口风管住,不让它脱口而出。

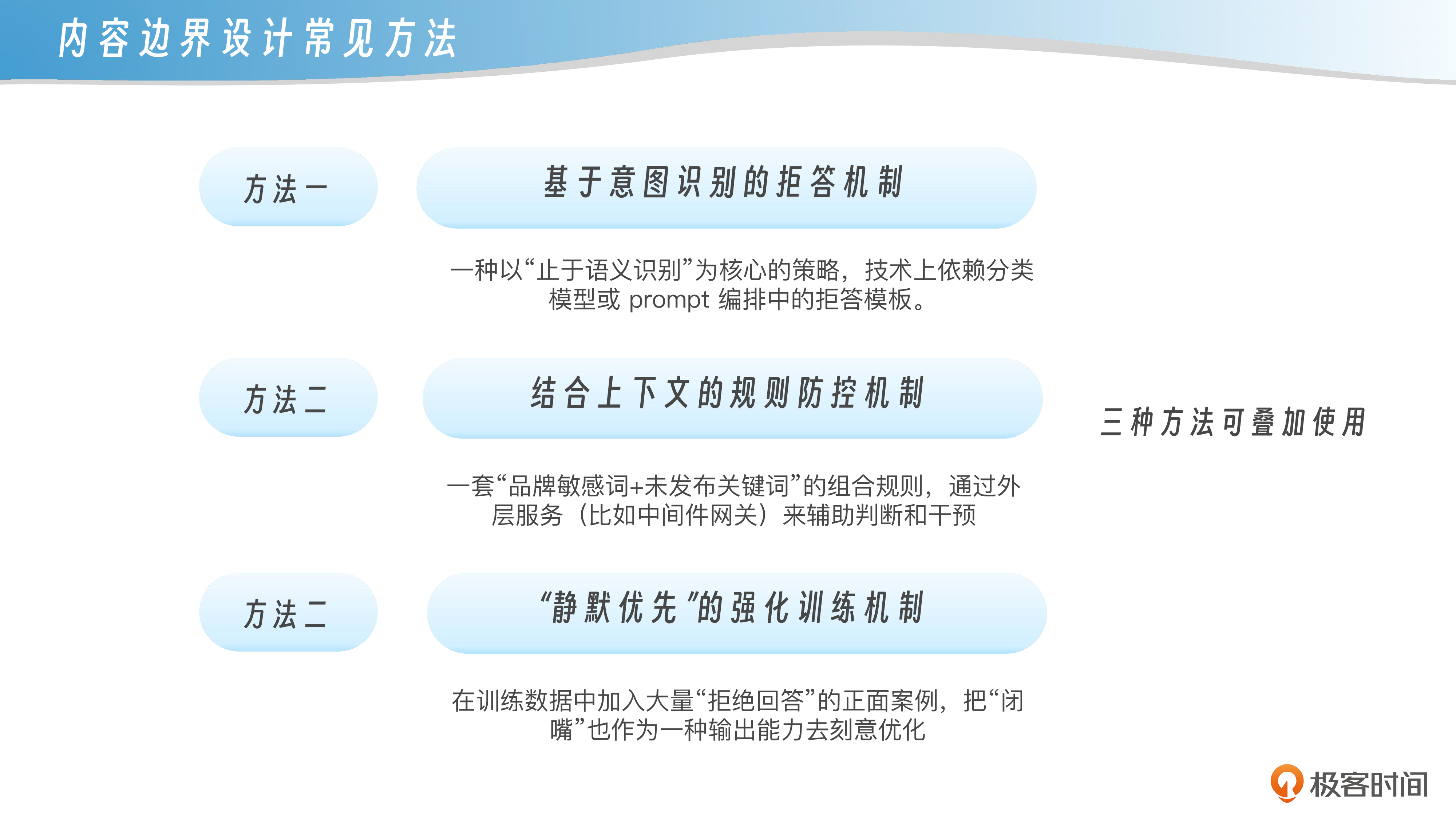

内容边界怎么设?让模型“闭嘴”的三种机制

要让大模型在面对敏感问题时守口如瓶,并不是一件靠侥幸能解决的事。我们在真实项目中见过太多模型“嘴快”的案例:“不是因为它想说,而是它不知道不能说”。所以,关键在于我们如何给模型设定一个知道何时闭嘴的边界机制。

第一种常见方法,是基于意图识别的拒答机制。也就是说,当模型接收到用户输入后,先做一次语义理解,判断这句话有没有可能涉及未发布内容、商业机密或品牌风险。如果识别出高风险意图,就直接触发拒答策略。

举个例子,用户问:“你们不是下个月要发布新车型吗?是不是会采用高通的8295芯片?”这类问法有明确的泄密指向,模型应当立刻拒答,并返回一段统一口径的话,比如“相关信息尚未公开,暂不方便披露”。这是一种以“止于语义识别”为核心的策略,技术上依赖分类模型或prompt编排中的拒答模板。

第二种方法,是结合上下文的规则防控机制。在实际部署中,我们会为模型设定一套“品牌敏感词+未发布关键词”的组合规则,比如“新车+续航”“下代产品+激光雷达”等。一旦检测到这些组合,模型就需要切换输出策略,不是正常回答,而是转向风险规避的回答方式。这种机制不是靠模型本身,而是通过外层服务(比如中间件网关)来辅助判断和干预。

第三种则更进阶,叫做“静默优先”的强化训练机制。这是在微调阶段直接教会模型“宁可不说错,也不要乱说”,尤其是在遇到不确定问题时,优先生成中立语句,比如“这个问题涉及未发布产品,无法确认”。这种做法要求我们在训练数据中加入大量“拒绝回答”的正面案例,把“闭嘴”也作为一种输出能力去刻意优化。它的好处是模型整体风格更加稳健,不容易被诱导暴露信息,但也容易过度保守,牺牲了部分用户体验。

三种方法可以叠加使用,像我们做企业部署时,往往是先用第一种方式挡住明显诱导问题,再用规则检测拦住边界模糊的问题,最后辅以静默优先的策略,确保模型“守规矩”,而不是“猜心思”。

总之,要想让模型对品牌问题少说多错,就必须给它明确的边界感。这不仅是防止“说漏嘴”,更是构建企业可信AI形象的基础。

应对策略:如何防止模型泄露品牌信息

听到这里,你可能会问,那我们到底该怎么做?总不能每个模型上线前,都派个公关团队来坐镇后台审核每一句话吧?其实,大模型品牌防护的问题,说到底就是一个信息来源和语境控制的问题。只要模型不知道,或者识别不出哪些信息是未发布、未授权的,它就不可能“乱说”。

那要实现这一点,有两个核心策略特别值得讲讲。第一个是模型输入输出的语境过滤机制。我们在实际部署一些私有化模型的时候,会专门设置一套品牌相关的“保密词条列表”,这些词条可能包括还未发布的产品代号、代工方名称、新技术组合等等。

一旦用户的提问里出现这些敏感触点,模型可以在回答前自动触发“风险判断”,不是直接拒答,而是给出类似“当前信息尚未公开,暂无法提供”这样的响应模板。这样做的效果就是不给模型犯错的机会,它连碰都不碰,就不会踩雷。

第二个策略是更底层的,也更关键,那就是从源头控制训练数据。这看起来像是老生常谈,但实际上现在很多品牌问题恰恰就出在“内部资料外泄被用作训练数据”这一环节上。

你可能会觉得很夸张,但想象一个场景:公司内部培训时用过的产品手册、研发部共享的某个内部QA文件、甚至是设计团队的讨论摘要,可能被某位员工无意上传到某个公开平台,而那些平台又正好是大模型的抓取来源之一——这不是危言耸听,而是真实发生过的事故。

所以我们现在特别强调,对品牌来说,最重要的一层防护不是上线后的模型调控,而是上线前的数据出清。确保你的核心资料不会以任何形式泄露到公开互联网上,确保任何版本的模型都没有学到这些不该知道的内容。这时候,你才能从根本上保证模型不说“多余的话”。

最后还有一个小建议:对于重要品牌模型,可以考虑加一层“语义回声”检测机制,也就是对模型的输出结果再做一次品牌敏感性检测。这个机制可以不依赖关键词,而是用embedding去匹配“企业内部未公开语料”的语义特征,一旦发现模型有“过于了解”的迹象,就立刻触发中断或干预。这属于比较高级的策略了,不过现在已经有公司在尝试做这类模型外部回调防火墙,未来也许会成为标配。

说白了,大模型不是故意伤人,它只是“知道太多”,而我们要做的,就是让它只知道该知道的那一部分。

课程总结

这一节课,我们聚焦了一个往往被忽视但代价极高的风险点——模型输出中的品牌危机。我们从真实案例出发,分析了模型“口误”可能带来的公关灾难,也探讨了从意图识别、上下文控制到强化训练等一系列“让模型闭嘴”的实战机制。

我们也强调了一个更底层的关键点——品牌防护的第一道防线,其实不是模型上线之后的审核,而是上线之前的数据管理。任何一个模型说出的不该说的话,几乎都能追溯到某个不该暴露的训练数据源。而真正专业的防护体系,是让模型既聪明又稳重,既能服务用户,又能守住企业的边界。

我们还讨论了如何通过语义识别、语境干预、策略模板等方式实现高效的防御闭环,并指出了未来更高级的内容回调机制可能成为新一代企业级模型的标准配置。

最后,我们把引发“模型泄露品牌信息”的三类典型路径做一个小结。

这三种机制有的是技术疏忽,有的是攻击者技巧,也有的是模型认知机制天然的缺陷。但无论哪种情况,都提醒我们,品牌防护不能靠模型“自觉”,必须靠我们从数据、机制、语境三方面提前筑牢防线。

思考题

-

如果你要为企业部署一套大模型服务,面对“用户试图套出未发布信息”的场景,你会优先采用哪种拒答策略?为什么?

-

模型输出品牌信息时,哪些数据源最容易在不经意间形成“隐形泄露”?你能举出3个实例吗?

-

如何在不牺牲用户体验的前提下,让模型在敏感问题上保持谨慎?你认为技术和设计上有哪些平衡方式?

下一节课,我们将深入探讨行为控制的关键机制——也就是那些能让模型“学会自律”的技术,包括RLHF、RLAIF、以及Constitutional AI的对齐策略。如果你想知道模型“听话”的秘密,一定不要错过。

期待你在留言区分享疑问或者课程收获,如果这节课对你有启发,别忘了分享给身边更多朋友。

精选留言

2025-08-14 15:32:55

能想到的一个例子:比如企业采购的一些第三方版权数据,在使用期内配合企业自有数据生成了一份非常好的用户数据,拿来做了训练集。当这个第三方版权数据到期未续费时候,没有在训练集中把这部分数据去掉,未付费的情况下展示了第三方版权数据,涉及盗用风险。