专栏上一期我介绍了单服务器高性能的PPC和TPC模式,它们的优点是实现简单,缺点是都无法支撑高并发的场景,尤其是互联网发展到现在,各种海量用户业务的出现,PPC和TPC完全无能为力。今天我将介绍可以应对高并发场景的单服务器高性能架构模式:Reactor和Proactor。

Reactor

PPC模式最主要的问题就是每个连接都要创建进程(为了描述简洁,这里只以PPC和进程为例,实际上换成TPC和线程,原理是一样的),连接结束后进程就销毁了,这样做其实是很大的浪费。为了解决这个问题,一个自然而然的想法就是资源复用,即不再单独为每个连接创建进程,而是创建一个进程池,将连接分配给进程,一个进程可以处理多个连接的业务。

引入资源池的处理方式后,会引出一个新的问题:进程如何才能高效地处理多个连接的业务?当一个连接一个进程时,进程可以采用“read -> 业务处理 -> write”的处理流程,如果当前连接没有数据可以读,则进程就阻塞在read操作上。这种阻塞的方式在一个连接一个进程的场景下没有问题,但如果一个进程处理多个连接,进程阻塞在某个连接的read操作上,此时即使其他连接有数据可读,进程也无法去处理,很显然这样是无法做到高性能的。

解决这个问题的最简单的方式是将read操作改为非阻塞,然后进程不断地轮询多个连接。这种方式能够解决阻塞的问题,但解决的方式并不优雅。首先,轮询是要消耗CPU的;其次,如果一个进程处理几千上万的连接,则轮询的效率是很低的。

为了能够更好地解决上述问题,很容易可以想到,只有当连接上有数据的时候进程才去处理,这就是I/O多路复用技术的来源。

I/O多路复用技术归纳起来有两个关键实现点:

-

当多条连接共用一个阻塞对象后,进程只需要在一个阻塞对象上等待,而无须再轮询所有连接,常见的实现方式有select、epoll、kqueue等。

-

当某条连接有新的数据可以处理时,操作系统会通知进程,进程从阻塞状态返回,开始进行业务处理。

I/O多路复用结合线程池,完美地解决了PPC和TPC的问题,而且“大神们”给它取了一个很牛的名字:Reactor,中文是“反应堆”。联想到“核反应堆”,听起来就很吓人,实际上这里的“反应”不是聚变、裂变反应的意思,而是“事件反应”的意思,可以通俗地理解为“来了一个事件我就有相应的反应”,这里的“我”就是Reactor,具体的反应就是我们写的代码,Reactor会根据事件类型来调用相应的代码进行处理。Reactor模式也叫Dispatcher模式(在很多开源的系统里面会看到这个名称的类,其实就是实现Reactor模式的),更加贴近模式本身的含义,即I/O多路复用统一监听事件,收到事件后分配(Dispatch)给某个进程。

Reactor模式的核心组成部分包括Reactor和处理资源池(进程池或线程池),其中Reactor负责监听和分配事件,处理资源池负责处理事件。初看Reactor的实现是比较简单的,但实际上结合不同的业务场景,Reactor模式的具体实现方案灵活多变,主要体现在:

-

Reactor的数量可以变化:可以是一个Reactor,也可以是多个Reactor。

-

资源池的数量可以变化:以进程为例,可以是单个进程,也可以是多个进程(线程类似)。

将上面两个因素排列组合一下,理论上可以有4种选择,但由于“多Reactor单进程”实现方案相比“单Reactor单进程”方案,既复杂又没有性能优势,因此“多Reactor单进程”方案仅仅是一个理论上的方案,实际没有应用。

最终Reactor模式有这三种典型的实现方案:

-

单Reactor单进程/线程。

-

单Reactor多线程。

-

多Reactor多进程/线程。

以上方案具体选择进程还是线程,更多地是和编程语言及平台相关。例如,Java语言一般使用线程(例如,Netty),C语言使用进程和线程都可以。例如,Nginx使用进程,Memcache使用线程。

1.单Reactor单进程/线程

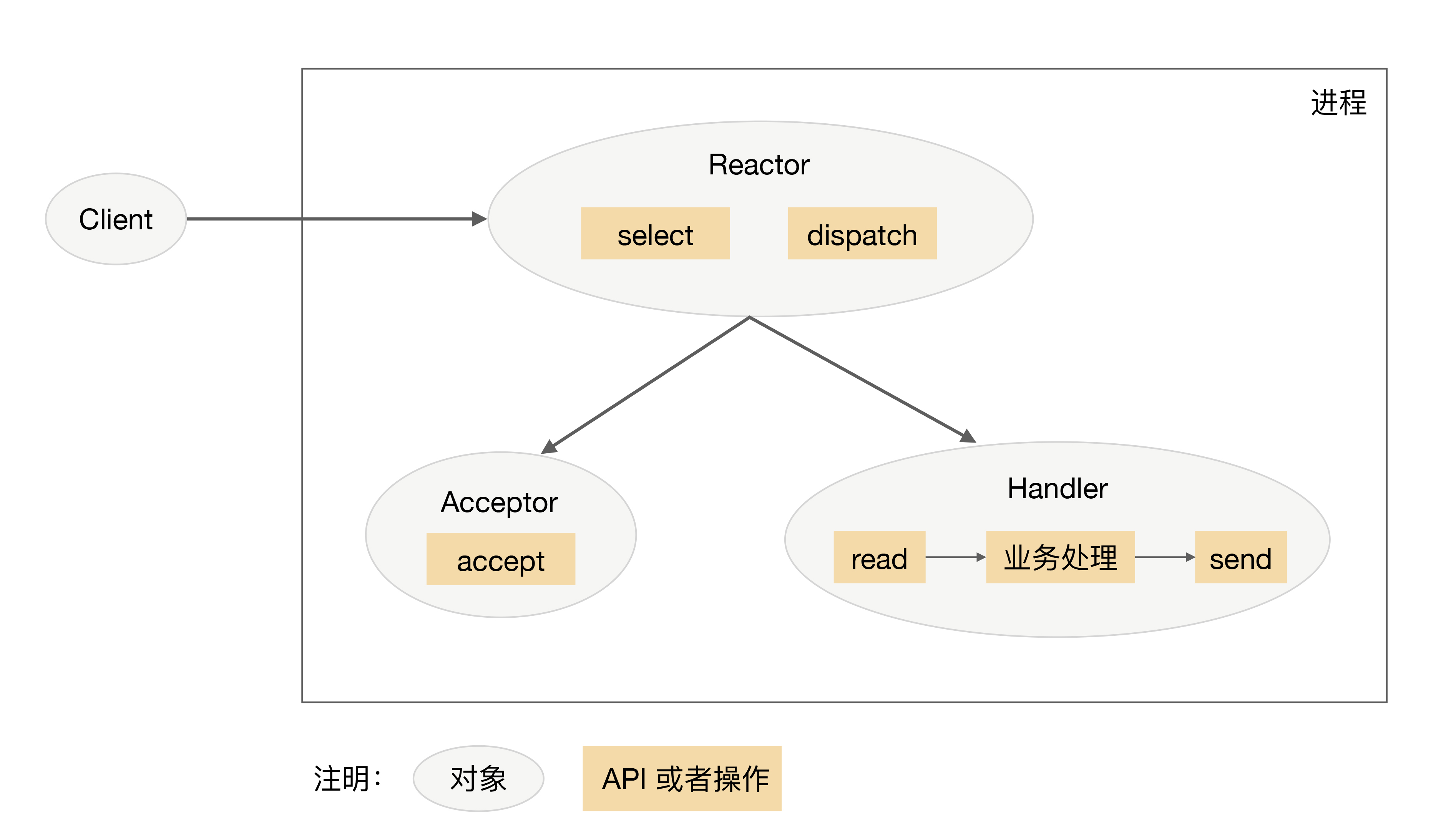

单Reactor单进程/线程的方案示意图如下(以进程为例):

注意,select、accept、read、send是标准的网络编程API,dispatch和“业务处理”是需要完成的操作,其他方案示意图类似。

详细说明一下这个方案:

-

Reactor对象通过select监控连接事件,收到事件后通过dispatch进行分发。

-

如果是连接建立的事件,则由Acceptor处理,Acceptor通过accept接受连接,并创建一个Handler来处理连接后续的各种事件。

-

如果不是连接建立事件,则Reactor会调用连接对应的Handler(第2步中创建的Handler)来进行响应。

-

Handler会完成read->业务处理->send的完整业务流程。

单Reactor单进程的模式优点就是很简单,没有进程间通信,没有进程竞争,全部都在同一个进程内完成。但其缺点也是非常明显,具体表现有:

-

只有一个进程,无法发挥多核CPU的性能;只能采取部署多个系统来利用多核CPU,但这样会带来运维复杂度,本来只要维护一个系统,用这种方式需要在一台机器上维护多套系统。

-

Handler在处理某个连接上的业务时,整个进程无法处理其他连接的事件,很容易导致性能瓶颈。

因此,单Reactor单进程的方案在实践中应用场景不多,只适用于业务处理非常快速的场景,目前比较著名的开源软件中使用单Reactor单进程的是Redis。

需要注意的是,C语言编写系统的一般使用单Reactor单进程,因为没有必要在进程中再创建线程;而Java语言编写的一般使用单Reactor单线程,因为Java虚拟机是一个进程,虚拟机中有很多线程,业务线程只是其中的一个线程而已。

2.单Reactor多线程

为了克服单Reactor单进程/线程方案的缺点,引入多进程/多线程是显而易见的,这就产生了第2个方案:单Reactor多线程。

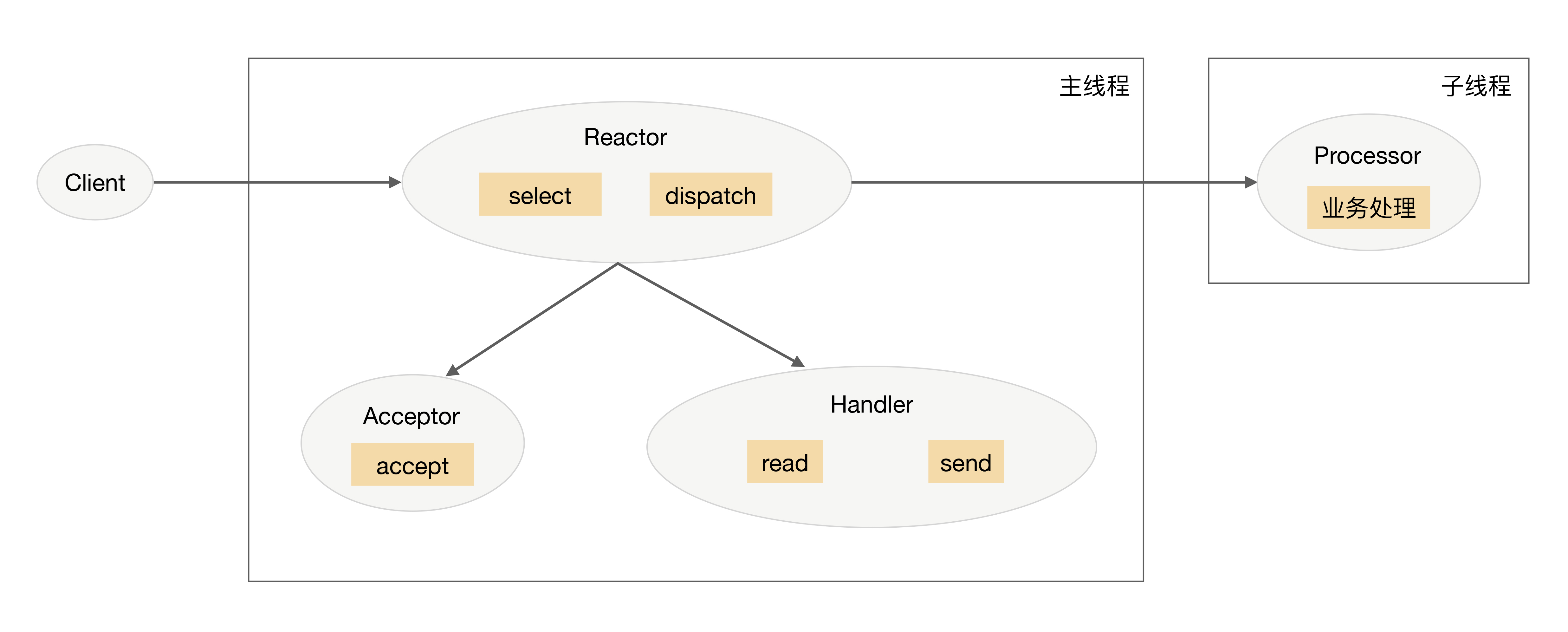

单Reactor多线程方案示意图是:

我来介绍一下这个方案:

-

主线程中,Reactor对象通过select监控连接事件,收到事件后通过dispatch进行分发。

-

如果是连接建立的事件,则由Acceptor处理,Acceptor通过accept接受连接,并创建一个Handler来处理连接后续的各种事件。

-

如果不是连接建立事件,则Reactor会调用连接对应的Handler(第2步中创建的Handler)来进行响应。

-

Handler只负责响应事件,不进行业务处理;Handler通过read读取到数据后,会发给Processor进行业务处理。

-

Processor会在独立的子线程中完成真正的业务处理,然后将响应结果发给主进程的Handler处理;Handler收到响应后通过send将响应结果返回给client。

单Reator多线程方案能够充分利用多核多CPU的处理能力,但同时也存在下面的问题:

-

多线程数据共享和访问比较复杂。例如,子线程完成业务处理后,要把结果传递给主线程的Reactor进行发送,这里涉及共享数据的互斥和保护机制。以Java的NIO为例,Selector是线程安全的,但是通过Selector.selectKeys()返回的键的集合是非线程安全的,对selected keys的处理必须单线程处理或者采取同步措施进行保护。

-

Reactor承担所有事件的监听和响应,只在主线程中运行,瞬间高并发时会成为性能瓶颈。

你可能会发现,我只列出了“单Reactor多线程”方案,没有列出“单Reactor多进程”方案,这是什么原因呢?主要原因在于如果采用多进程,子进程完成业务处理后,将结果返回给父进程,并通知父进程发送给哪个client,这是很麻烦的事情。因为父进程只是通过Reactor监听各个连接上的事件然后进行分配,子进程与父进程通信时并不是一个连接。如果要将父进程和子进程之间的通信模拟为一个连接,并加入Reactor进行监听,则是比较复杂的。而采用多线程时,因为多线程是共享数据的,因此线程间通信是非常方便的。虽然要额外考虑线程间共享数据时的同步问题,但这个复杂度比进程间通信的复杂度要低很多。

3.多Reactor多进程/线程

为了解决单Reactor多线程的问题,最直观的方法就是将单Reactor改为多Reactor,这就产生了第3个方案:多Reactor多进程/线程。

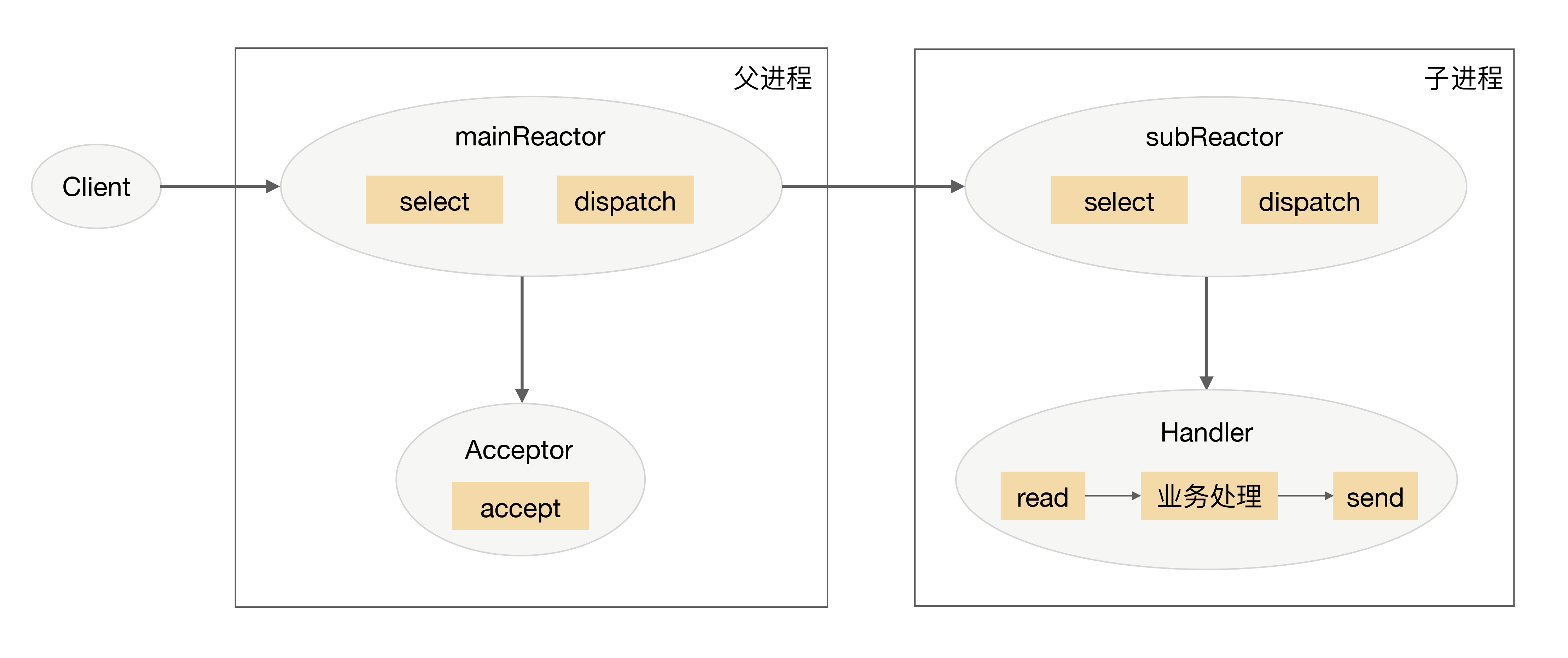

多Reactor多进程/线程方案示意图是(以进程为例):

方案详细说明如下:

-

父进程中mainReactor对象通过select监控连接建立事件,收到事件后通过Acceptor接收,将新的连接分配给某个子进程。

-

子进程的subReactor将mainReactor分配的连接加入连接队列进行监听,并创建一个Handler用于处理连接的各种事件。

-

当有新的事件发生时,subReactor会调用连接对应的Handler(即第2步中创建的Handler)来进行响应。

-

Handler完成read→业务处理→send的完整业务流程。

多Reactor多进程/线程的方案看起来比单Reactor多线程要复杂,但实际实现时反而更加简单,主要原因是:

-

父进程和子进程的职责非常明确,父进程只负责接收新连接,子进程负责完成后续的业务处理。

-

父进程和子进程的交互很简单,父进程只需要把新连接传给子进程,子进程无须返回数据。

-

子进程之间是互相独立的,无须同步共享之类的处理(这里仅限于网络模型相关的select、read、send等无须同步共享,“业务处理”还是有可能需要同步共享的)。

目前著名的开源系统Nginx采用的是多Reactor多进程,采用多Reactor多线程的实现有Memcache和Netty。

我多说一句,Nginx采用的是多Reactor多进程的模式,但方案与标准的多Reactor多进程有差异。具体差异表现为主进程中仅仅创建了监听端口,并没有创建mainReactor来“accept”连接,而是由子进程的Reactor来“accept”连接,通过锁来控制一次只有一个子进程进行“accept”,子进程“accept”新连接后就放到自己的Reactor进行处理,不会再分配给其他子进程,更多细节请查阅相关资料或阅读Nginx源码。

Proactor

Reactor是非阻塞同步网络模型,因为真正的read和send操作都需要用户进程同步操作。这里的“同步”指用户进程在执行read和send这类I/O操作的时候是同步的,如果把I/O操作改为异步就能够进一步提升性能,这就是异步网络模型Proactor。

Proactor中文翻译为“前摄器”比较难理解,与其类似的单词是proactive,含义为“主动的”,因此我们照猫画虎翻译为“主动器”反而更好理解。Reactor可以理解为“来了事件我通知你,你来处理”,而Proactor可以理解为“来了事件我来处理,处理完了我通知你”。这里的“我”就是操作系统内核,“事件”就是有新连接、有数据可读、有数据可写的这些I/O事件,“你”就是我们的程序代码。

Proactor模型示意图是:

详细介绍一下Proactor方案:

-

Proactor Initiator负责创建Proactor和Handler,并将Proactor和Handler都通过Asynchronous Operation Processor注册到内核。

-

Asynchronous Operation Processor负责处理注册请求,并完成I/O操作。

-

Asynchronous Operation Processor完成I/O操作后通知Proactor。

-

Proactor根据不同的事件类型回调不同的Handler进行业务处理。

-

Handler完成业务处理,Handler也可以注册新的Handler到内核进程。

理论上Proactor比Reactor效率要高一些,异步I/O能够充分利用DMA特性,让I/O操作与计算重叠,但要实现真正的异步I/O,操作系统需要做大量的工作。目前Windows下通过IOCP实现了真正的异步I/O,而在Linux系统下的AIO并不完善,因此在Linux下实现高并发网络编程时都是以Reactor模式为主。所以即使Boost.Asio号称实现了Proactor模型,其实它在Windows下采用IOCP,而在Linux下是用Reactor模式(采用epoll)模拟出来的异步模型。

小结

今天我为你讲了单服务器支持高并发的高性能架构模式Reactor和Proactor,希望对你有所帮助。

这就是今天的全部内容,留一道思考题给你吧,针对“前浪微博”消息队列架构的案例,你觉得采用何种并发模式是比较合适的,为什么?

欢迎你把答案写到留言区,和我一起讨论。相信经过深度思考的回答,也会让你对知识的理解更加深刻。(编辑乱入:精彩的留言有机会获得丰厚福利哦!)

精选留言

2018-06-10 08:16:13

2018-06-11 13:14:34

1、假如我们去饭店点餐,饭店人很多,如果我们付了钱后站在收银台等着饭端上来我们才离开,这就成了同步阻塞了。

2、如果我们付了钱后给你一个号就可以离开,饭好了老板会叫号,你过来取。这就是Reactor模型。

3、如果我们付了钱后给我一个号就可以坐到坐位上该干啥干啥,饭好了老板会把饭端上来送给你。这就是Proactor模型了。

2018-06-15 16:55:59

2018-06-09 13:44:24

1、单Reactor单进程/线程

redis采用这种模式,原因是redis是基于内存的数据库,在处理业务会非常快,所以不会对IO读写进行过长时间的阻塞,但是如果redis开启同步持久化后,业务处理会变慢,阻塞了IO线程,也就无法处理更多的连接了,而我们的消息中间件需要消息的高可靠,必定要同步持久化,如果异步的话,就看异步持久化的时间间隔了,假设500ms持久化一次,那就有可能会丢失500ms的消息。当然华仔分析的无法利用多核cpu的特性也是一大缺点;虽然我们要求的TPS不算很高,但是QPS很高了,所以我觉得这种模式不合适

2、单Reactor多进程/线程

这种模式我觉得也不是和合适,虽然真正的业务处理在独立的线程了,IO线程并没有被阻塞,可以处理更多的连接和读写事件。我们的中间件可能不会面对海量的连接数,但是会面对大量的读请求,瓶颈是在处理读操作上,跟单Reactor单进程/线程差别不大;我倒觉得前一讲说的TPC prethread 模式是合适的,有独立的线程负责read-业务处理-send。

3、多Reactor多进程/线程

这种模式是最合适的了,不过华仔在讲解是read→业务处理→send,业务处理还是在IO线程上,如果业务处理的慢,还是会阻塞IO线程的,我觉得最好是业务处理放到独立的线程池里面去,这就变成了mainReactor负责监听连接,subReactor 负责IO读写,后面的业务线程池负责真正的业务处理,这样就既可以面对海量的连接,海量的请求也可以支撑。

不知理解的是否正确?

2018-06-10 16:00:45

2018-06-10 21:17:38

多线程or多进程,实际工作中,基本多线程模型,可以单线程事件检测,多线程分派,也可以多线程轮流事件检测和分派。可以参考leader-follwers pattern。

io模式,一般都使用non-block。

与acceptor-connector模式结合使用,可进一步分离模块职责(即将 服务初始化与 服务逻辑分离. 由reactor统一进行事件驱动)

附一个自己开发的reactor框架

https://github.com/zhaozhencn/cute

2018-06-09 19:13:30

之前学习NIO和AIO的时候是这么描述的:进程请求IO(无论是硬盘还是网络IO),先让内核读取数据到内核缓存,然后从内核缓存读取到进程。这里面就有2个IO等待时间,第一个是读取到内核缓存,第二个是读取到进程。前者花费的时间远远大于后者。在第一个时间中进程不做等待就是NIO,即非阻塞。第二个时间中进程也不需要等待就是AIO,即异步。

第一个问题:文章中说Reactor 是非阻塞同步网络模型,因为真正的 read 和 send 操作都需要用户进程同步操作。这里的read和send指的是我上面说的第二个时间吗?

第二个问题:因为我理解你的“来了事件我来处理,处理完了我通知你”。这里的我来处理就是包括第一和第二个时间吗?

感觉我之前被误解了,是我哪个地方理解不对吗?麻烦解答一下。

2018-06-11 16:05:31

阻塞&非阻塞

这一组概念并偏向于系统底层的实现,常与OS进程调度相关。 以socket为例,在阻塞模式下线程A调用recv函数,若此时接收缓冲区有数据,则立即返回,否则将进入”阻塞状态“(主动释放CPU控制权,由OS CPU调度程序重新调度并运行其它进程),直到”等待条件”为真,再由OS将此进程调度并重新投入运行。非阻塞模式则另辟蹊径,无论有无数据均立即返回(有数据则返回数据,无数据则返回错误值), 不会影响当前线程的状态。 从某种意义上讲,阻塞模式下,一个线程关联一个文件fd, 常引起线程切换与重新调度,对于高并发环境,这种代价太大。而非阻塞模式则解耦了“1线程关联1文件fd"。

同步&异步

调用与执行的分离即为异步,否则为同步。其实包括两个层面,其一为请求方(客户方),其二为执行方(服务方),抛开这两个概念单独讨论同步或异步是片面的。若请求方调用执行方的服务并等待服务结果,则为同步过程。但对于一些耗时或IO服务,服务执行时间往往较长或不可控,并可能导致降低整体服务质量,此时需要将调用与执行解耦。 有些经典设计模式常用于解决此问题: 1 command(命令模式)-- 将请求封装成命令对象,实现请求方对命令执行的透明化, 2 Active Object(主动对象)-- 对象内部驻留一个线程或线程池,用于执行具体服务,同时,对象对外提供服务接口,供请求方发起调用(可能获得Future对象)。

2018-06-14 14:29:24

2021-06-25 06:26:02

总结:

少连接,多请求 - PPC/TPC

多连接,多请求

- 单Rector 单线程 (无法充分利用内核,需要业务处理迅速)

- 单Rector 多线程 (复杂度较高,应对瞬间高并发能力较差)

- 多Rector 多线程 (复杂度比 单Rector多线程 低,强化应对高并发的能力)

疑问:

1. 多Rector多线程 相比于其他Rector模式的缺点是什么, 既可以充分利用内核,复杂度不错,也有一定应对高并发的能力,岂不是万金油的选择?

2. 多Rector多线程/进程 的模式和PPC/TPC很像,都是在请求连接的时候开始新线程/进程 进行处理,这两者之间有什么区别?

后浪微博的场景会有多连接,多请求(访问量),并且可能存在高并发的场合, 所以可以采用多Rector多线程(分析错的话希望指点)

2018-08-16 11:33:17

打个比方,我们去点心店吃碗面,首先先得去收银台点单付钱,同步阻塞的情况是:我点了碗辣酱加辣肉面,然后我就在收银台等着,等到面来了,我拿着面去吃了,后面所有的人都无法点单无法下单(即使后面的人点的是已经做好的大排面也不能付钱拿面,老子还没好 你们谁都不许动),而reactor(同步非阻塞)的情况是我点了碗辣酱加辣肉面,钱付好以后我就拿着号去座位上坐下了,等面好了后,服务员会叫“XXX号,你的面好了,自己来取”(服务员帮你送上来的叫proactor),这里收银台就是reactor或者叫dispatcher,店里会有一个小二定时的轮询去看XXX号的XXX面有没有好,好了以后就通知XXX你可以来拿面了,没好你就等着呗。多reactor就是把收钱 下面 通知的事分成几个人 由不同的人来做

2018-07-16 08:27:04

2018-08-19 22:15:45

2018-12-02 16:29:56

2018-07-14 15:44:08

之前的留言中有一个类比成去餐厅吃饭的例子还是蛮恰当的,肯德基麦当劳里面是reactor模式,需要用户先领个号然后等叫号取餐;海底捞和大多数中餐厅就是paractor模式,下完单后服务员直接将食品送过来。

回到文章中的问题,消息中间件的场景是链接数少请求量大,采用多进程或多线程来处理会比较好,对应单reactor还是多reactor应该都可以。

2018-07-07 22:24:35

redis是使用单reactor单进程模式。缺点是handler在处理某个连接上的业务时,整个进程无法处理其他连接的事件。

但是我做了个测试,在redis里面存放了一个1000w长度的list,然后使用lrange 0 -1全取出来,这会用很久。

这时候我新建个连接,继续其他key的读写操作都是可以的。不是应该阻塞吗?

2018-06-23 10:55:04

2018-06-10 19:21:09

2018-11-14 10:02:37

2018-07-05 16:54:19